理解 Java 内存模型(JMM) 和 CPU 缓存一致性机制之间的底层关联,将硬件层的“总线协议”与 Java 层的“可见性、有序性”概念建立联系。

✅ 一、什么是总线嗅探(Bus Snooping)

总线嗅探 是多核 CPU 为了解决 缓存一致性问题(Cache Coherence) 而采用的一种硬件协议机制。

👨🏫 举个例子:

假设两个 CPU 内核分别有各自的缓存(L1、L2),线程 T1 在 CPU1 上将变量 x = 10 缓存在本地,线程 T2 在 CPU2 上读取 x,但还没刷新。这就出现了缓存不一致的问题。

为了保证数据一致性,CPU 采用了 MESI 协议 + 总线嗅探技术:

所有 CPU 核心都会“监听”系统总线上对共享变量的读写指令。

当某个核心修改了某个缓存数据,它会通过总线广播“我修改了 x”,其他 CPU 若有缓存 x,就会将其设为无效(Invalid)。

这样可以保证多核缓存间的数据一致性。

🧠 简单理解:就像你在办公室修改了一份公共文档,你会大声告诉大家“这页我改过了”,其他人就不会继续看旧版本。

✅ 二、什么是总线风暴(Bus Storm)

当多个线程/CPU 核在高频率地读写共享变量,并且反复触发总线嗅探广播通知时,会造成:

系统总线被高强度占用;

多个核心不断地失效自己的缓存并重新读取;

CPU 空转、性能抖动严重。

这就是所谓的 总线风暴(Bus Storm),本质上是一种缓存一致性通信机制的性能瓶颈。

✅ 三、它们与 Java 内存模型(JMM)有什么关系?

☑ JMM 和 CPU 缓存一致性协议之间的桥梁:

Java 内存模型(JMM)是一个 语言级的抽象模型,而总线嗅探是 CPU 的硬件协议机制。JMM 必须依赖底层 CPU 实现可见性、原子性、有序性。

💡 二者的关系举例:

✅ volatile与总线嗅探最直接相关:

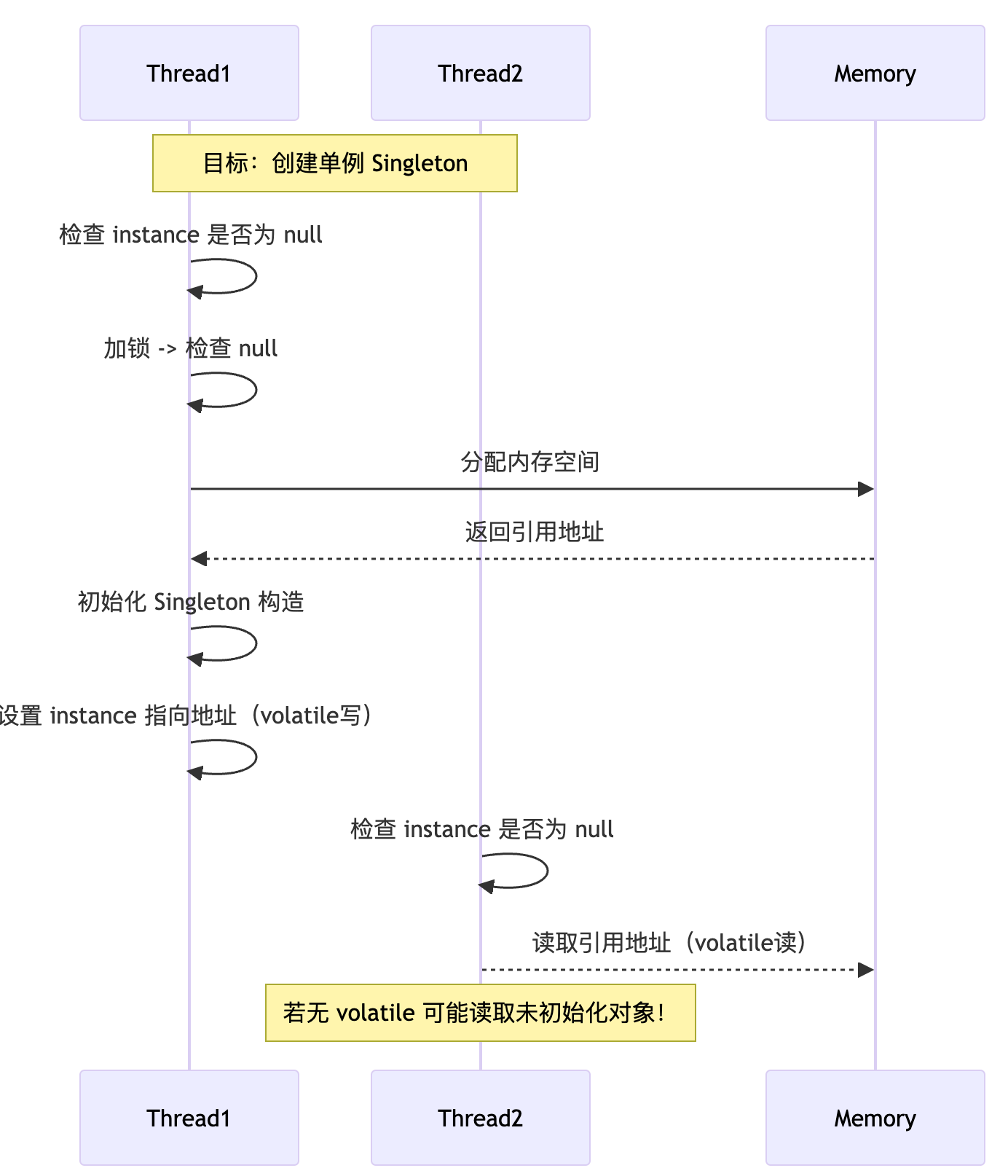

使用 volatile 修饰字段时,写操作会刷新主内存,并使其他线程的缓存失效;

JVM 在 volatile 写前插入 Store Barrier,写后插入 StoreStore / StoreLoad 屏障;

这个刷新过程最终会由 硬件通过总线嗅探实现。

✅ 四、内存屏障(Memory Barrier)在 JVM 中的角色与对应汇编指令

你是否知道 Java 层的 volatile 实现依赖底层硬件原语?熟悉内存屏障分类?

🔹 Java 层 → JVM → 汇编层 对应关系:

💡 总结:

屏障作用:强制 CPU 执行特定顺序的内存访问;

锁前缀指令 lock:不仅原子,还会刷新写缓冲区,形成全屏障(full fence);

x86 天然强一致性,但 arm/ppc 架构需更多 barrier(关注平台差异);

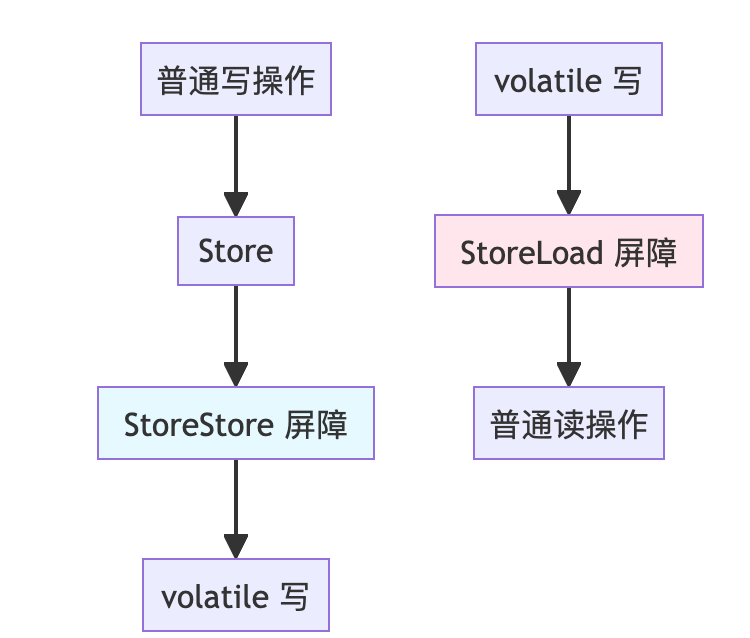

✅ 五、 volatile 的写屏障与读屏障插入位置(可视化)

StoreStore 确保之前的写不能与 volatile 写重排序,StoreLoad 则防止后续读被提前。

✅ 六、深入理解 JMM “happens-before” 规则 与 volatile 的匹配

🔍 常见的 happens-before 规则(JLS 定义):

☑ volatile 匹配:

对 volatile 写 → 对应的读可见(建立 happens-before)

即写先行发生于读,跨线程建立内存屏障与通信

✅ 七、自旋锁 vs 阻塞锁的性能对比

🧠 头脑风暴:

AQS 如何自适应自旋?

何时自旋,何时阻塞?(Hybrid策略)

✅ 八、volatile + DCL 示例补图

✅ 九、🧠 头脑风暴:

✅ 总结

Java 并发的本质,是在 JVM 层屏蔽了底层复杂的 CPU 缓存一致性协议和内存顺序模型;而 volatile 就是最直观的例子,它依赖总线嗅探和屏障指令完成跨线程的可见性同步。通过理解硬件机制(MESI、lock 前缀、cache coherence),我们可以更合理地使用 volatile、原子类和锁,避免性能陷阱与隐性 bug。

评论区